L’intelligence artificielle n’est plus réservée aux laboratoires :elle organise nos playlists, filtre nos emails, évalue notre solvabilité, aide les médecins à repérer une tumeur ou les recruteurs à présélectionner des CV.

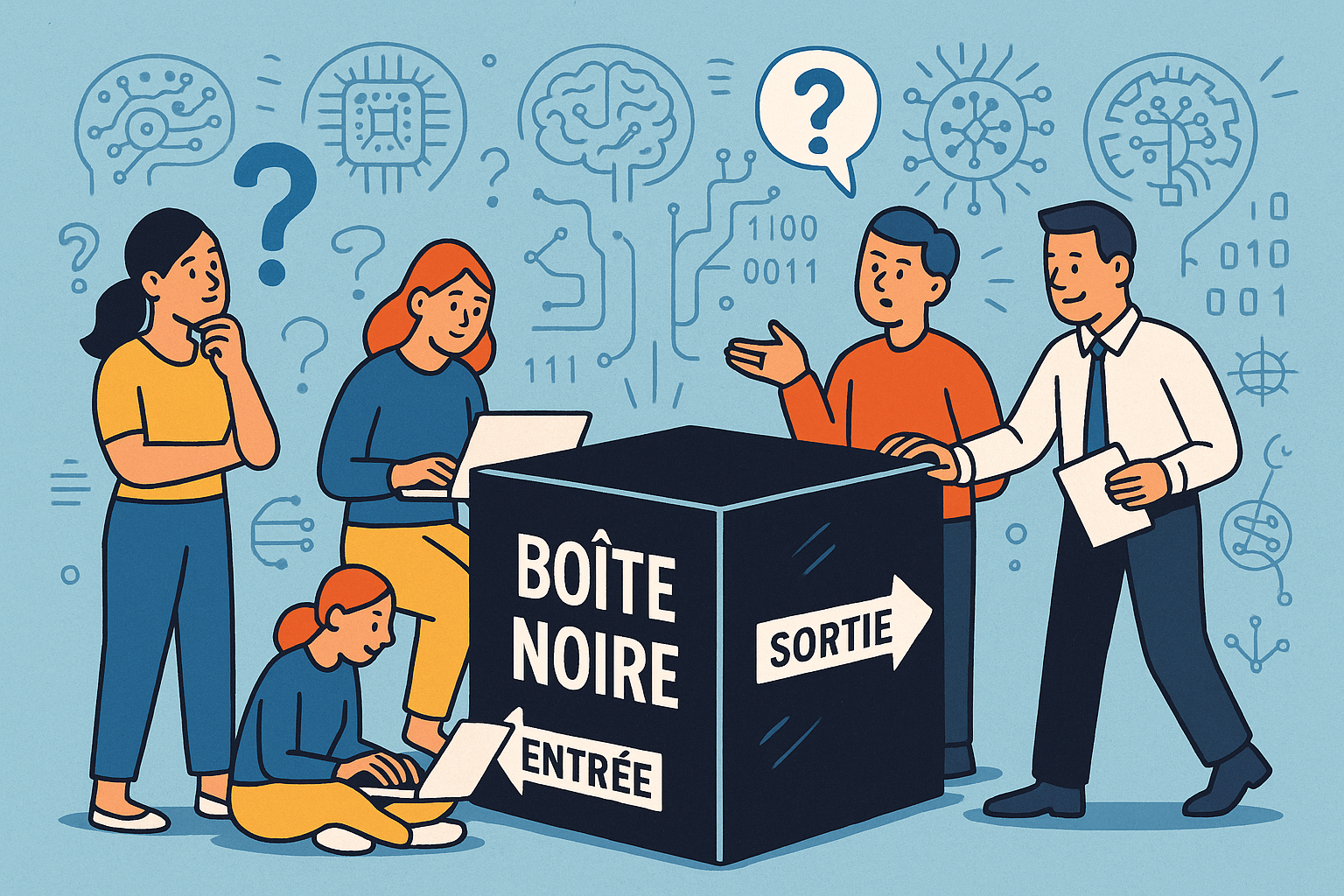

Chaque jour, sans même nous en rendre compte, nous confions des micro‑décisions à des algorithmes. Or, la plupart du temps, ces systèmes fonctionnent comme un micro‑ondes: on place une entrée, on obtient une sortie… sans jamais observer ou comprendre ce qui se passe derrière la porte.

Cette zone aveugle, on l’appelle la boîte noire.

Qu’est‑ce qu’une « boîte noire » ?

Définition courte : dispositif dont on connaît l’entrée et la sortie mais pas le procédé intermédiaire.

Trois analogies parlantes :

- Micro‑ondes : un plat cru, un plat chaud, mais qui sait réellement comment les ondes excitent les molécules ?

- Cafetière à capsules : dosette + eau → espresso crémeux ; pression, température et turbines restent invisibles.

- Boîte aux lettres : vous glissez une carte, elle arrive à destination ; quel itinéraire ? quels centres de tri ? mystère.

Dans l’IA : la boîte noire est un réseau de neurones contenant des millions à milliards de “vis” numériques (paramètres) qui s’ajustent pendant l’entraînement. Même le concepteur ne peut plus dire quel poids précis a déclenché quel verdict.

Pourquoi cette opacité se produit‑elle ?

Comprendre le « pourquoi » est plus simple si l’on pense à un atelier : parfois la machine est trop complexe, parfois elle se reconfigure toute seule, parfois elle tourne en continu. Voici les quatre raisons principales — décryptées avec des images concrètes.

Trop de pièces en mouvement – l’effet “moteur d’avion”

🔧 Ordre de grandeur : un vélo ≈ 200 pièces ; une voiture ≈ 5 000 ; un gros avion ≈ 2 millions. GPT‑4 manipule plus d’un trillion de “vis” numériques.

🧩 Pourquoi c’est opaque : à cette échelle, expliquer chaque boulon reviendrait à commenter grain par grain une plage entière — pendant qu’une tempête souffle dessus.

🗝️ À retenir : plus il y a d’éléments, plus la vue d’ensemble devient nébuleuse, même pour l’ingénieur qui a conçu la machine.

Interactions non linéaires – la “recette de grand‑mère”

🍰 Dans un gâteau, retirer un seul œuf ne divise pas le moelleux par deux ; modifier sucre et levure et cuisson peut changer la texture du tout au tout.

🧠 De même, une décision d’IA résulte d’un faisceau de micro‑influences. Une connexion isolée compte peu ; des milliers qui bougent ensemble transforment la sortie.

🗝️ À retenir : il n’existe pas un interrupteur « oui/non » ; la logique est un patchwork permanent de petites forces.

Apprentissage automatique – l’élève autodidacte

📚 Un collégien qui voit 100 exemples de verbes finit par deviner la conjugaison du 101ᵉ. L’enseignant n’a pas écrit toutes les règles ; l’élève les a induites.

🖩 L’IA procède pareil : elle avale des millions d’exemples puis code ses propres raccourcis dans un gigantesque tableau de nombres. Ces « règles » ne sont pas des phrases, mais des décimales.

🗝️ À retenir : impossible de lire ces « règles » comme dans un manuel scolaire ; elles ne sont lisibles que pour la machine.

Évolutivité permanente – le jardin qui pousse la nuit

🌱 Un détecteur de fraude apprend de nouveaux stratagèmes chaque heure. Ses paramètres « poussent » en continu, comme un jardin qu’on découvrirait différent chaque matin.

🔄 Conséquence : le raisonnement d’hier n’est plus exactement celui d’aujourd’hui. Sans journal détaillé, reconstituer le chemin est aussi ardu que de déduire toutes les étapes de croissance d’un arbre à partir de ses cernes.

🗝️ À retenir : même une IA décrite aujourd’hui redevient partiellement opaque demain si elle continue d’apprendre sans suivi clair.

D’ailleurs savez-vous pourquoi le même prompt n’offre pas toujours la même réponse ?

Vous avez peut‑être remarqué que relancer ChatGPT avec exactement la même question n’aboutit pas toujours au même texte. Ce n’est pas un bug mais une fonctionnalité.

Vous avez peut-être remarqué qu’en posant exactement la même question à une IA comme ChatGPT à deux moments différents, vous n’obtenez pas toujours la même réponse. Ce comportement peut surprendre, mais il est parfaitement logique. Et cela nous ramène directement à la notion de « boîte noire ».

L’IA ne fonctionne pas comme une base de données figée. Elle est conçue pour générer ses réponses de manière dynamique, en s’appuyant sur une mécanique d’apprentissage qui intègre une certaine dose d’incertitude, ce que les ingénieurs appellent la « température ». Une température plus élevée pousse l’IA à être plus créative, à varier davantage ses formulations. Résultat : même question, formulations différentes.

Mais cela va plus loin. L’IA ne sait pas dans un sens humain. Elle ne cherche pas une réponse toute faite : elle prédit, mot après mot, ce qui a le plus de chances de suivre la question, comme un joueur de Scrabble qui anticipe le prochain mot possible. Cette méthode peut donc produire plusieurs chemins, tous plausibles, depuis le même point de départ.

Et comme toute boîte noire, l’IA tient aussi compte du contexte. Si vous discutez depuis dix minutes de marketing, et que vous tapez le mot « campagne », elle vous proposera probablement une stratégie publicitaire. Mais si vous veniez de parler écologie ou géographie, elle vous répondrait sans doute en évoquant les champs et les tracteurs. Le sens dépend du fil.

Enfin, certaines IA évoluent au fil du temps, à travers des mises à jour. Même si elles ne « retiennent » pas vos conversations, leur base de fonctionnement peut être réajustée, affinée. D’une semaine à l’autre, leurs réponses peuvent donc changer subtilement, même sans que vous vous en aperceviez.

En clair : une IA n’est pas une calculette. C’est un système dynamique, probabiliste, contextuel. Et dans une boîte noire, ces éléments internes ne sont pas visibles. Savoir cela nous permet de mieux interpréter ses réponses, de ne pas s’en remettre aveuglément à une formulation, et surtout, de garder un esprit critique face à ses suggestions.

Les risques d’un regard aveugle

Même sans avoir besoin de comprendre les détails mathématiques d’un algorithme, il est possible de percevoir les dangers de l’opacité en IA. Voici cinq exemples concrets qui montrent à quel point une décision non expliquée peut poser problème car une IA peut commettre des erreurs.

Prenons d’abord la question de la confiance. Imaginez qu’un algorithme médical signale une masse suspecte sur une radio. Si l’IA ne fournit pas d’explication visuelle – comme une carte indiquant la zone problématique – le radiologue peut hésiter à suivre cette recommandation. Ce doute peut entraîner un traitement inutile… ou au contraire, un risque de passer à côté d’un problème réel.

Autre cas : les biais. Un filtre antispam peut apprendre qu’un mot comme « Enron » est un bon indicateur de fiabilité, simplement parce qu’il était souvent présent dans des emails internes jugés légitimes lors de son entraînement. Résultat : tous les messages contenant ce mot passent les mailles du filet, même s’ils sont malveillants. Et à l’inverse, des messages valides d’autres expéditeurs peuvent être injustement bloqués.

La question de la responsabilité se pose également. Si une banque refuse automatiquement un prêt sans fournir de justification claire, le client n’a aucun moyen de contester. Et l’établissement ne peut pas non plus prouver que la décision a été prise de manière juste ou conforme aux règles. L’opacité empêche donc toute discussion constructive.

La réputation est aussi en jeu. Supposons qu’un système de tri de CV défavorise systématiquement les candidatures féminines, sans que cela soit visible à première vue. Le jour où cette discrimination est révélée, l’entreprise s’expose à un scandale, des poursuites judiciaires, et la perte de talents qu’elle cherchait justement à attirer.

Enfin, la sécurité peut être compromise. Si un véhicule autonome freine brusquement sans qu’on sache pourquoi, il devient très difficile de savoir si la réaction était appropriée, s’il faut corriger le logiciel, ou s’il y a eu une erreur humaine. Sans trace ni justification, l’amélioration continue devient presque impossible.

En résumé, tant qu’une décision d’IA reste opaque, personne – ni l’utilisateur, ni le concepteur, ni le régulateur – ne peut vérifier si elle est correcte, équitable ou améliorable.

L’xAI comme réponse ?

L’XAI, pour eXplainable Artificial Intelligence (ou IA explicable en français), désigne un ensemble de méthodes et d’approches visant à rendre compréhensibles les décisions prises par une intelligence artificielle, en particulier quand elle repose sur des modèles complexes comme ceux du deep learning.

Que fait l’XAI concrètement ?

Elle cherche à répondre à des questions simples, comme :

- Pourquoi l’IA a-t-elle donné cette réponse ?

- Quelles données ont influencé sa décision ?

- Que se passerait-il si je changeais un paramètre ?

Pour cela, elle utilise différentes techniques (qui devront faire l’objet d’un prochain article car là il est déjà bien long) :

- LIME ou SHAP : pour comprendre quelles variables influencent le plus une décision individuelle.

- Contre-factuels : pour simuler des scénarios alternatifs (« si le revenu de cette personne avait été plus élevé, aurait-elle eu le prêt ? »).

- Visualisation de réseaux neuronaux : pour voir comment un modèle “voit” une image ou comprend un texte.

Alors, que faire ?

Il ne s’agit pas de rejeter l’IA, ni de tomber dans la défiance systématique. Mais de retrouver une forme d’exigence dans notre manière de l’utiliser.

Cela passe par trois attitudes simples, mais fondamentales :

1. Se former, un peu mais vraiment. Pas besoin de devenir data scientist. Mais comprendre ce qu’est un modèle, un biais, un prompt bien structuré, c’est comme apprendre à lire une carte avant de prendre le volant. Sans ça, on peut avancer… mais sans savoir où on va.

2. Revenir à une posture active. L’IA ne doit pas être une béquille permanente, ni un oracle moderne. Chaque réponse est une hypothèse à interroger, à adapter. Copier-coller une sortie brute, c’est déléguer sa pensée. Or, penser, c’est décider.

3. Exiger de la transparence. Que ce soit dans les outils que nous utilisons, les décisions qui nous concernent, ou les systèmes que nos entreprises déploient : demander des comptes, des explications, des garde-fous, c’est poser les bases d’une IA digne de confiance.

L’intelligence artificielle ne doit pas être subie. Elle doit être comprise, débattue, maîtrisée.C’est le seul moyen d’éviter que la magie ne prenne le pas sur le sens.